skrill

Actif-

Compteur de contenus

27 -

Inscrit(e) le

-

Dernière visite

Réputation sur la communauté

0 NeutreÀ propos de skrill

- Date de naissance 08/09/1971

Information du profil

-

Genre

Homme

-

Localisation

Aubagne

-

skrill a commencé à suivre Problème mot clé de contenu dans la search console

-

Problème mot clé de contenu dans la search console

skrill a ajouté un sujet dans Techniques de Référencement

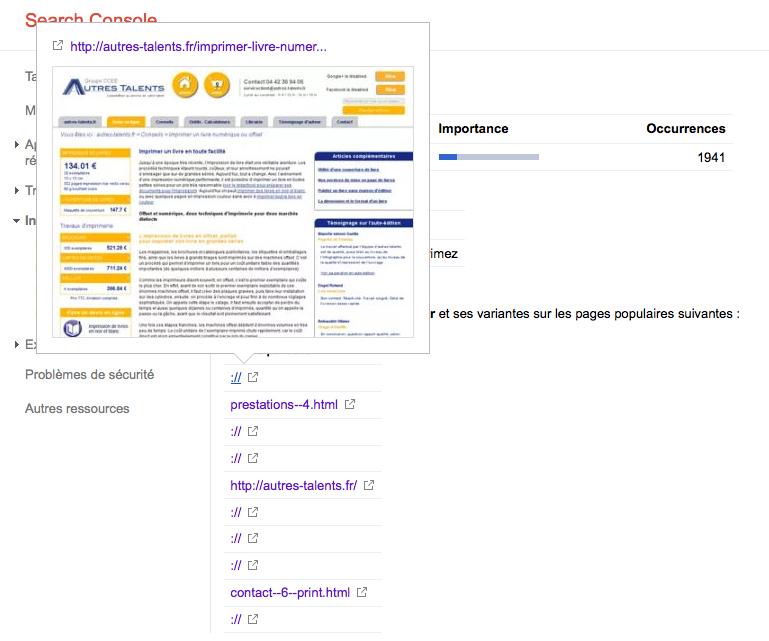

Bonjour J'ai un soucis dans la search console qui doit être du aux url (enfin je pense) Pour ceux qui connaissent l'onglet mots clé de contenu dans la search console, je joint un screen Le problème est qu'au lieu d'avoir l'url en ancre j'ai un "://" sur les url de second degrés (du type rubrique / sous rubrique) mais toutes les autres url apparaissent correctement. Ce problème est apparu il y a un mois a peu près suite à une mise à jour du site avec implémentation du script politique de confidentialité (tarteaucitron) Ce week-end j'ai supprimer le script pour voir si il y avais un effet, mais pour le moment rien de neuf Ce problème n'apparait pas dans les liens internes ou ailleurs dans la search console. Je n'ai a priori pas de lien mort ou de lien 410/404 non désirable suite à cette implémentation Donc si quelqu'un a eu ce problème ou si vous avez des pistes je suis preneur, parce que là je sèche. Piste [g+, cannonical, hreflang...] pour l'url du site voir le screen merci à tous. cordialement Skrill -

Rewriting problème de virgule urls cassées

skrill a ajouté un sujet dans Fichier .htaccess et réécriture d'URLs

Bonjour à tous, Je me trouve face à un problème cornelien, j'ai pas mal cherché et je ne trouve pas de solution. Les bots crawler, me trouve des urls cassées juste avant la première virgule de mes urls. Ce qui donne des belles 404 qui remonte dans GWT et dans mes logs apache J'ai bien entendu passé un xenuh pour voir si ce n'était pas le site qui générait ces urls. J'ai aussi fait des tests sur ces url dans les moteurs de recherche et sur site de seo, voir si ce n'était pas un site qui me faisait ces liens et... nada. Ce bug est remonté suite à une correction dans mon htaccess que j'avais écrit avec le nom du site (pages d'erreurs personnalisées), donc toutes ces pages sortaient en 302 au lieu de 404. Le GWT me dit que ces url viennent de mon sitemap. J'ai regardé mon site map, rien de spectaculaire. toutes les balises sont là, Les virgules ne sont pas encodées elles sont écrites : ",". => Faut-il encoder en %C2 ? si oui quel impact pour le référencement ? Voici la structure des urls : http://exemple.com/rubrique/sousrubrique/titre-de-la-page--id1,id2,id3,id4.html comme vous l'aurez compris l'url qui est crawlée est : http://exemple.com/rubrique/sousrubrique/titre-de-la-page--id1 La règle de réécriture : RewriteRule ^rubrique/([-a-zA-Z0-9]*)/([-a-zA-Z0-9]*)--([0-9]*),([0-9]*),([0-9]*),([0-9]*)\.html$ index.php?id1=$3&id2=$4&id3=$5&id4=$6 [L,QSA] Extrait de log apache 66.249.67.133 - - [03/Jul/2014:07:00:28 +0200] "GET /rubrique/sousrubrique/titre-de-la-page--2 HTTP/1.1" 404 527 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" Un exemple de redirection (vu que j'ai fait un rewriting récement : RewriteRule ^ancienrep/rubrique/titre-de-la-page--id1,id2,id3\.html$ http://example.com/rubrique/sousrubrique/titre-de-la-page--id1,id2,id3,id4.html [R=301] Donc voilà, je ne comprends vraiment pas pourquoi ces urls tronquées apparaissent alors qu'elles n'existent nulle part. Merci pour votre intérêt et vos réponses. Cordialement Skrill -

Bonjour à tous, Le but de mon script : comparer les lignes d'un tableau et afficher la valeur la plus petite ce script doit marcher pour 2 colonnes et plus J'ai plusieurs dimension dans ce tableau je crée un tableau ou je stock les valeurs des colonnes je crée un tableau ou je stock les valeurs des lignes je crée une matrice ou je stock les valeurs des cellules $reqsql1 = GET_TABLE(requete sql); for ($f=0; $f<count($reqsql1); $f++) { $sort_id = tabl requetesql1; $f_id[] = $sort_id; // insertion des éléments dans le tableau (colonnes) $var2 = $f_id[$f]; $reqsql2 = GET_TABLE(requete sql); for ($c=0; $c<count($reqsql2 ); $c++) { $produit_id = tabl reqsql 2; $p_id[] = $produit_id; // insertion des éléments dans le tableau (lignes) $var = $p_id[$c]; $fus[$var2][$var] = array(current($constructeur[$f][$c]['valeur'])); // insertion des valeurs d'un tableau associatif dans le tableau (valeur des cellules) } } Mon soucis maintenant, et si j'ai la bonne logique (enfin j'espère) c'est de pouvoir extraire et afficher la plus petite valeur de cellule en fonction d'une ligne mon tabelau ressemblerait à ça : -------1-8 1-----10-50 2-----20-39 10---30-26 pour la ligne 1 je dois sortir la valeur 10 pour la ligne 2 la valeur 20 pour la ligne 3 la valeur 26 cela doit fonctionner pour 2 à x colonne J'espère avoir été assez clair Merci d'avance

-

crawling d'url en boucle /init/mass_start_stop.cgi

skrill a répondu à skrill - Forum : Les Navigateurs

A priori le blocage par le robot.txt fonctionne, mes pages sont de nouveaux crawler. Cependant, tous les bots ne sont pas respectueux de ce fichier. Cela va donc poser problème. Comment me débarrasser définitivement de ce "script" qui "force" les robots à crawler cette url ? Y-a-t-il un fichier log qui m'indiquerait les script qui sont exécutés quand il y a une requête sur mon domaine ? -

crawling d'url en boucle /init/mass_start_stop.cgi

skrill a répondu à skrill - Forum : Les Navigateurs

Je suis d'accord avec toi dan. Cependant sur une page qui n'existe pas et de plus avec une extension en .cgi je ne m'en fait pas pour les contenus dupliqués. g**gle lit mon robbots.txt le matin donc j'aurais la réponse demain pour voir si les crawler bots respectueux du robbots.txt arretent de crawler cette url extra terrestre. J'ai testé mon robbots de le webmaster tool et il bloque normalement cette url. Merci pour la précision au sujet des répertoires je vais pouvoir alléger le robbot.txt au vu de ces nouvelles informations qui m'avaient échappées. Enfin ce qui m'inquiète vraiment c'est d'une part l'url avec un .cgi et d'autres part que les crawler bot qui d'habitude crawlent une 10aines de pages de mon site tous les jours se focalise sur cette url et ne crawlant plus rien d'autres. -

crawling d'url en boucle /init/mass_start_stop.cgi

skrill a répondu à skrill - Forum : Les Navigateurs

merci Dan, Mon soucis n'est pas la redirection que je maîtrise a peu près C'est que les robot crawleur ne s'intéressent qu'a une seule url qui n'est même pas sur le site. A terme mes pages ne seront plus crawler et vont perdre des positions; Mes nouvelles pages ne seront plus crawler non plus. D'ou le soucis que faire pour que les robbots fonctionne normalement à nouveau -

bonjour à tous, Je ne sais pas si c'est la bonne section pour ce genre de problème, n'hésitez pas à déplacer le sujet au cas ou. Depuis trois jour les bots crawler bloque tous sur la même url : h**p://domaine/init/mass_start_stop.cgi il crawle en boucle toujours cette url. GGbot est même venu 172 fois hier... Du coup il ne crawle plus les autres pages de mon site. Ce qui a terme va être plus qu'ennuyeux au niveau du référencement. J'ai rediriger cette url qui sortait en 404 vers ma home histoire de voir ce qui se passait mais les bots continu a crawler cette page qui n'existe pas. Je ne comprend pas pourquoi tous les bots cherche cette url qui n'existe pas sur le site. Et surtout pourquoi ils bouclent tous sur cette même recherche. Quels sont vos avis et solutions. Merci d'avance Skrill

-

% dans une adresse et rewriting

skrill a répondu à skrill - Forum : Fichier .htaccess et réécriture d'URLs

Pas élégant soit ! mais cela fonctionne. Merci Jean-luc pour cette réponse efficace. -

% dans une adresse et rewriting

skrill a ajouté un sujet dans Fichier .htaccess et réécriture d'URLs

Bonjour à tous, Un petit sousci de rewriting que je n'arrive pas à élucider. J'ai fait des liens qui ont mal été interprété par spip et je ne m'en suis pas rendu compte lors de la soumission. Le petit spip à donc interprété mes '--' par '%E2%80%94' Je cherche donc à rewriter l'url avec les '%E2%80%94' j'ai donc essayer de type d'écriture sans succès RewriteRule ^repertoire1/sousrepertoire/mon-titre-de-page%E2%80%945,18\.html$ repertoire1/sousrepertoire/mon-titre-de-page--5,18.html [R=301,L,QSA] Merci d'avance. -

Bonjour à tous, Je suis à la recherche d'un petit script de commentaires comme on voit dans les forum par exemple. Avec Bdd et admin pour la gestion des indésirables. Que je puisse l'adapter en php. Merci d'avance.

-

Mes 301 fonctionnent correctement. Donc wait and see du moment que ce n'est pas pénalisant

-

Bonjour à tous, J'ai renommer des urls qui j'ai rediriger en 301. Jusque là rien de spécial. Simplement ça fait bien 3 semaines et que j'ai la nouvelle et l'ancienne url qui sont toutes les deux indéxées. J'avais imaginer que la nouvelle url écraserait l'ancienne mais ce n'est pas le cas. A votre avis je dois demander la suppression de l'ancienne url ? ou alors attendre encore ? Ou je me suis rater dans la procédure à employer ? Merci d'avance.

-

Problème de url rewriting

skrill a répondu à nico.riv - Forum : Fichier .htaccess et réécriture d'URLs

Oui en effet des fois j'ai du mal a te suivre. Et pourquoi ne pas faire des dossiers virtuel et mettre tout tes fichiers dans le même dossier ? Avec le nom des rubriques en dur ou en BDD ensuite tu customises ton rewriting et tu réécris tout tes liens T'es sur de vouloir dire que ton index.php est une erreur 404 ? ErrorDocument 404 /admax_v2/index.php j'aurais plus tendance à faire une page 404.html et faire une redirection vers l'index. -

Problème de url rewriting

skrill a répondu à nico.riv - Forum : Fichier .htaccess et réécriture d'URLs

Tu sais a faire du rewriting on en a tous bavé a un moment, il faut savoir être tenace. Si tu me dis que ça fonctionne ca doit être la première règle RewriteRule ^index\.php\?dossier=([a-z]+)$ /admax_v2/accueil/index.php?dossier=$1 RewriteRule ^adamax_v2/dossier=([a-z]+)/([a-z]+)\.php$ admax_v2/index.php?dossier=$1&page=$2 si $2 est du texte sinon il faut écrire ([0-9]*) par exemple par des chiffres Je pense que tu n'es pas très loin de la solution, si le "/" te fait une erreur 500 essaye l'échappement "\/" -

Problème de url rewriting

skrill a répondu à nico.riv - Forum : Fichier .htaccess et réécriture d'URLs

A droite tu affiche l'url existante sans le http, à tester avec ou sans tes répertoires adamax_v2 et accueil ca donnerai /admax_v2/accueil/index.php?dossier=$x ( à ce stade on ne connait pas l'indice de la variable) Je ne sais pas comment sont construite tes url en dur dans ton code dans la balise <a href="xxxx"> Je ne comprend pas pourquoi tu tiens absolument à écrire index.php qui ne te servira à rien dans l'optimisation des url Le début c'est ce qui va être affiché dans ton url en remplacement de l'ancienne les échappements testes avec et sans RewriteRule ^index\.php\?dossier=([a-z]+)$ Donc au final ca fait RewriteRule ^index\.php\?dossier=([a-z]+)$ /admax_v2/accueil/index.php?dossier=$1 ($1 par ce qu'il n'y a qu'une seule variable à récupérer : ([a-z]+) ) tout ce qui n'est pas une variable tu l'écrits en dur et aussi dans la construction de tes liens dans ta source ou alors essayer de passer avec ce type d'écriture à voir les possibilités RewriteCond %{QUERY_STRING} ^dossier=([a-z]+)$ RewriteRule ^index\.php$ http://tondomaine.fr/admax_v2/accueil/index.php?dossier=%1? [L,QSA] bon courage